如今,人工智能(AI)已越来越广泛地应用于各个领域,但随着AI技术的发展成熟,人们对其又爱又怕的矛盾感也正日益突出。无论是未雨绸缪,还是危言耸听,有关人工智能威胁论的声音从未消失过。

今年2月,韩国科学技术院(KAIST)开设人工智能武器实验室,用于研发配备致命武器的人工智能机器人,即所谓的“杀手机器人”,消息一出便引发广泛抵制。

据《南华早报》报道,4月4日,来自全球28个国家及地区的50余名顶尖人工智能专家宣布,将联合抵制KAIST,并终止与该院的一切联系合作,以示抗议,直至其停止研发自主武器。

公开信发出后,KAIST迫于压力于近日宣布,新开设的实验室将不会参与研发任何自主武器系统及杀手机器人,国际AI专家的抵制活动也随之结束。

为何全球顶尖专家如此恐惧“杀手机器人”?人工智能技术发展到今天究竟有多大的隐患?

事实上,不同于普通大众对人工智能技术失控或产生失业危机的担忧,科技人士对人对于人工智能最大的担忧是,人工智能具有从根本上改变战争方式的潜力,稍有不慎,人工智能就能将“人vs人”的战争变成“机器自主性杀人”的战争,成为毁灭性的战争武器。

“呼吁禁止使用“攻击性自动武器”,一旦越过界限,将开启新一轮全球军备竞赛。”

AI专家已意识到自主武器的危险

纷纷拒绝进行相关研发

尽管人工智能在当前军事领域的应用,大部分集中于排除路障、地雷、或是在极端环境下进行探测等辅助功能,但并不等于它的能力仅限于此。正是意识到自主武器将会带来怎样的毁灭性灾难,AI领域的专家们纷纷拒绝进行相关领域的研发,以彻底灭掉杀人机器人出现的可能性。

▲2013年4月在伦敦举行的“停止杀人机器人”运动中,一个模拟杀人机器人被展示出来 图据网络

近年来,不断有科技界知名人士对人工智能未来的影响发出预警。

已故物理学家史蒂芬·霍金生前也曾三番五次表态,人工智能可能会毁灭人类。在他看来,人工智能的成功有可能是人类文明史上最大的事件,但也有可能是人类文明史的终结。

连硅谷“钢铁侠”埃隆·马斯克,也是人工智能的反对者,他在2014年就曾表示,要警惕人工智能,因为它们比核武器更加危险。去年8月,他又带头签署了联合公开信,敦促联合国采取措施禁止杀人机器人的开发,担忧人工智能可能引发第三次世界大战。

比尔·盖茨也曾直言,虽然人工智能的发展前景广阔,但人工智能在未来几十年会成为人类的心头大患。

2015 年 7 月,来自世界各地的几千名AI专家联合签署了一封公开信,呼吁联合国禁止超出人类控制的攻击性自主武器。加利福尼亚大学伯克利分校的AI专家斯图尔特·拉塞尔教授表示,机器人武器系统或将使人类“毫无防御能力”。

同样在2015年7月,阿根廷布宜诺斯艾利斯召开的“人工智能国际联合会”上,史蒂芬·霍金、埃隆·马斯克、苹果联合创始人史蒂夫·沃兹尼亚克与上千名AI及机器人专家发布公开信,呼吁禁止使用“攻击性自动武器”,一旦越过界限,将开启新一轮全球军备竞赛。

▲2016年,美国警方用炸弹处理机器人杀死一名达拉斯枪击嫌疑人,引发社会担忧 图据《大众科学》杂志

科学家们在公开信中指出,自主武器已被视为继火药与核武器之后的第三次武器革命,而人工智能技术目前的发展已经使部分自动武器在几年内,而不是几十年内,就将成为可能。

他们十分担心,在有效法令颁布前,就会有不需人类下达最终执行命令的杀人机器人伤及无辜。毫无疑问,一旦出现,这些机器人最终流入黑市或落入恐怖分子或独裁者手中,不过只是时间问题。

可以想象,这种可怕情形,就是电影《终结者》中的场景真实上演。

▲电影《终结者2》中的骨架机器人 图据网络

这也是为何各国专家对于KAIST的计划,有如此激烈的反应。一旦有世界顶尖研究机构开启了这个“潘多拉魔盒”,无疑将加速杀手机器人的诞生,加速全球 AI 军备竞赛,进而导致第三次世界大战加速到来。而这场战争的杀伤力和规模都将是前所未有、远超想象的。

在50余名专家抗议KAIST的同时,科技巨头谷歌公司的3100名员工联名上书CEO桑达尔·皮恰伊,要求公司退出与五角大楼合作的代号Maven的AI军事项目。

Maven项目于2017年4月开启,目的是通过人工智能技术提高军事效率。而谷歌公司负责向国防部提供帮助军方自动分析识别图像中物体的技术,这引发了不少员工的担心,他们称这种技术有可能用于提升无人机袭击的瞄准能力。

据《纽约时报》报道,谷歌员工同时还要求公司宣布一项“永不开发战争技术”的政策,绝不卷入战争,染指军事技术,并牢记公司座右铭:“永不作恶。”

▲谷歌员工联名信截图 图据《纽约时报》

“人工智能技术发展如果趋向恶的一面,则无疑于打开了潘多拉魔盒,异常凶险。”

智能机器引领的自主战争时代已临近

禁止致命自主武器迫在眉睫

这样的担忧并非耸人听闻的阴谋论。

在科幻剧《西部世界》中,有自主意识的机器人开始拿起武器对抗人类。而在现实世界中,日益智能和自动化的机器人,正被当作武器创造出来,一个由智能机器引领的自主战争时代已经悄然临近。

目前,全球超过16个国家,甚至是ISIS这样的恐怖组织,已拥有了武装无人机,各国军队正竞相在海陆空加速部署自主式武器。《华尔街日报》分析指出,尽管目前这些武器仍在人类操控下运行,但这种情况或许不会持续太久。

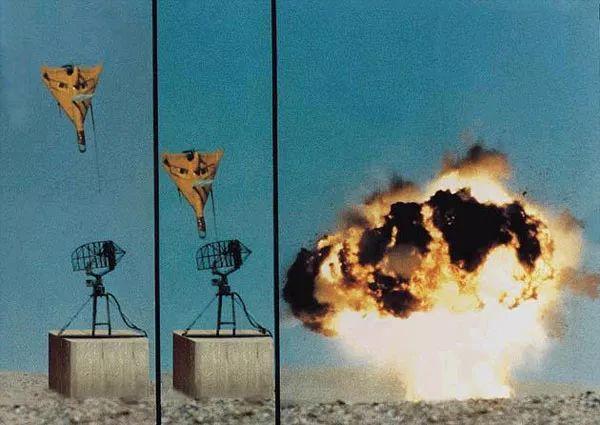

2016年,以色列发布新一代人工智能武器“哈比”无人机,这是一款攻击型自主武器,发现目标雷达便能不经请求,自主撞击引爆。尽管以色列方面表示,“哈比”是用来攻击雷达,而不是人类,然而“哈比”的诞生仍然给军事人工智能领域带来了极大冲击。

▲以色列的“哈比”无人机可自主攻击目标雷达 图据网络

尽管目前,没有国家宣布计划建造全自动杀人机器,但各国正在加速自主武器的研发,则是毫无疑问的。这让越来越多的人开始担忧,距离这些武器能够自主选择攻击目标的那一天,不远了。一旦这些武器拥有了如“哈比”无人机一样的自主权,会发生什么?

2017年11月,在日内瓦举行的联合国武器公约会议上,播放了一段可怕的视频:视频中,一群仅有蜜蜂大小的小型机器人,通过人脸定位瞬间杀死正在上课的一整班学生。

这样一个小型“杀手机器人”配备有广角摄像头、传感器、面部识别、3克炸药,能穿透建筑物、汽车,躲过子弹,反应速度比人类快100倍。一旦接收到目标图像信息,就能实现99.99%的超精准打击,任何伪装都是无效的。

尽管在视频结尾,AI专家斯图尔特·拉塞尔教授表示,这段视频和杀人机器人并非真实,但这样的科技目前已经存在。拉塞尔教授通过视频描绘了一个杀人机器人存在的恐怖未来,呼吁众人要避免视频中的悲剧发生,需要尽快行动。

想象一下,这些致命的自动武器一旦落入恐怖分子之手,将会造成怎样的后果。

拉塞尔教授的观点,并不是少数派,在不少人工智能界的顶尖专家看来,人工智能技术发展如果趋向恶的一面,则无疑于打开了潘多拉魔盒,异常凶险。

在专业人士多年的努力号召下,联合国方面也开始正视致命型自主武器带给世界的胁迫感。KAIST风波后,据法新社报道,4月9日联合国迅速召开《特定常规武器公约》大会,80多个来自世界各国的军事人工智能专家齐聚日内瓦,开启了为期一周的关于致命自主武器的系统讨论。

自2017年11月14日联合国首次就“如何限制致命自主武器”进行讨论后,这已是相关人士第五次在瑞士日内瓦对其参与讨论。

这足以看出,这一问题的紧迫性。

与此同时,一个由65个非政府组织组成的联盟“阻止机器人杀手战役”表示,攻击选定目标的自主式致命武器,早已不再属于科幻小说范畴。现在,全球应先发制人,禁止它们的到来。这些武器成为危险的现实,已进入倒计时阶段,希望联合国能在2019年前出台相关禁令。

“这些没有生命的机器无法理解或尊重生命的价值,但它们却有能力决定何时带走生命。”组织创建者之一的玛丽·威勒姆表示,这一旦成为现实,将会是多么可怕的灾难。

发布于:四川